老人说:“不管去哪里,你都不得不做一些错事,这是生命的基本条件,要求你违背自己认同的身份。在某些时候,每个活着的生命都必须这么做。这就是终极的阴影,造物的缺陷。这是终极诅咒,那个吞噬所有生命的诅咒。整个宇宙都是这样。”

—— 《仿生人会梦见电子羊吗?》 第 138 页

人工智能,是人类对于人造智能的终极幻想。在 2022 年机器学习的算法革命爆发之后,人们越来越关注当今 AI 的发展。而我作为一名对科幻和计算机超级感兴趣的人,也一直在关注人工智能的发展。

广义上的人工智能,其实是一个自动化系统,它会根据当前所处的环境做出智能化的决策,并对环境施加影响。而从这个定义看,我们人类其实是比较高级的“自动化系统”。

2025 年人工智能可能迎来的退潮

关于训练侧可能已经到头,通过数据、算力、参数规模的大模型推进方式已经到头,目前在推理侧利用堆算力的方法,实现模型性能的进一步提升。

而要能提升到什么程度,就要看思维链能够优化到什么程度了。

本质

AI 并不是什么洪水猛兽,关于它的本质,我有以下的一些了解。这些内容是我在阅读了大量的文献和很多人的思考之后得到的。

AI 三要素:

数学上限

根据吴军博士在《计算之魂》这本书中,将所有问题分为四类:

| 问题 | 极限 |

|---|---|

| 可判定问题 | 马季雅谢维奇证明,很多问题无法判定是否有解 |

| 有答案的问题 | 代表有解的问题,比可判定问题要少 |

| 可计算的问题 | 图灵机可解的问题 |

| 工程上可解的问题 | 例如有限时间内不可解的问题,或者计算复杂度理论超过指数函数的问题 |

AI 能处理的问题,都是工程可解问题当中的一个子集。其实涵盖的范围异常小。人类社会中的许多哲学问题,日常生活的选择,都无法等效为纯理性的数学问题。人的选择,更多的是情绪化和随机化的,而所谓的“人心难测”便是这个道理。

AI 能够在很多地方做的比人要好,那是因为问题在数学上找到了解决的路径。

有意思的是,在 o1 发布之后,Zhiyuan Li 在证明了思维链可以在理论上解决所有的数学问题。[2402.12875] Chain of Thought Empowers Transformers to Solve Inherently Serial Problems

AI 的智能等价于设计者的智能

吴军的导师库旦普教授,就曾经对 AI 的智能来源作出过总结,他认为 AI 的智能取决于两个方面:

- 系统设计者的智能水平

- 系统使用的硬件水平和数据量的多寡

换句话说,AI 的智能边界早就被人本身和它可以接触到的数据和算力决定了,所以,能自我进化的 AI 只会存在于科幻小说中。

对人类所有信息的综合

科幻小说作家特德·姜对 ChatGPT 的看法可以用一句话概括:

ChatGPT 的本质,是一张互联网所有文本的“模糊图像”

我认为很有道理,因为以计算机技术为代表的信息技术,本身就是在提升处理信息的能力,而机器学习大大加强的也是信息处理能力,这一点本质没有变化。

直到 2024 年底,AI 所呈现出来的强项,还是在于对信息的综合,整理和模仿生成,这一切没有脱离 AI 作为“信息工具”的本质。

算法,就是对信息的计算和汇总。而就 GPT、StableDiffusion 或者 Sora 而言,当我们在使用他们时,我们使用的是超强的信息处理能力。

缩放定律

通俗理解缩放定律,就是“量变引起质变”。例如大规模的模型参数,大量的数据,长时间的训练,大量的算力投入会引发 AI 的“顿悟”现象。

例如,小参数模型无法做对算数题,无法笑话背后的幽默含义。但是通过加入更多的参数,使用更多的数据训练,模型会“自然”习得这些能力而不需要人为的介入。

从神经网络的结构来看,这点非常好理解。更多的神经网络层,意味着模型能够捕捉更为细微,更为抽象的特征。这就好像在小参数模型中“无处安放”的一个对某个概念的理解,在大参数模型中就可以随意找到它的位置。

所以,“理解”本身可能就是一个空间概念。当我们将一个概念放在一个正确的位置,并与周围概念建立起合理连接的时候,我们就理解了一个概念。

算法

当今人工智能的发展是由算法和数据共同驱动的。在目前我们使用的主流算法是神经网络算法。这是一个经典的机器学习算法。而机器学习算法多种多样,刚好神经网络是最能够合理处理现有的数据,得到效果也比较好的算法。这也从侧面应证了,不论是 GPT 还是什么主流的 AI 工具,其能够解决的问题范畴,还是极为局限的。

时间上的缩放定律

看 AI 的训练过程,如果把数据和参数看作空间维度,那么计算时长就可以看作时间维度。更多的训练数据可以加强模型的性能。

相应地,训练时长可以影响模型的拟合效果。那么 OpenAI o1 的经验证明,推理时长也会影响模型的输出效果。即模型的思考时间越长,那么获得输出的效果也就越好。

这就是时间上的缩放定律。

数据

数据量是 AI 进化的养料。没有高质量的数据有没有高质量的模型,所谓 Garbage In Garbage Out 就是这个意思

公有数据的枯竭

截止 2023 年底,AI 已经将大部分高质量的文本使用完毕。然而,更多的图像或者视频数据仍然可用,但是这部分数据并不是特别好处理,而且如果要处理好需要大量的算力代价。

专家数据的开发

哪里可以找到更多的数据?

Alexandr Wang 认为:

一方面,更高质量的数据可能需要购买才能获得。另一方面,大量的高级数据(例如各行各业的私有数据和高水准数据)仍待开发,这部分数据虽不易获得,但是价值极高。

高价值的数据在半导体,汽车,IT,生物制药和产品制造等各个领域,这些数据面临两个问题:不公开和未结构化。但是一旦能够使用,大模型取得的优势将是压倒性的。

我在社交媒体上也有看到一部分人正在从事行业数据的结构化整理,训练模型的工作,而我认为,这部分工作的进展速度并不会很快,因为现存的法律壁垒将会有多重博弈。但是,我认为这的确是人类社会发展的一个大方向。也许新一代的专家系统将会出现,并颠覆各行各业。

能源和算力

AI 使用的算力巨大,消耗巨大电力,使用大量能源。但是直到目前,大家的共识还是当前 AI 使用的能源比起智能带来的进步,还是值得的。

例如,OpenAI 和微软筹备的星际之门项目,将使用大量能源为 AI 提供算力。据了解,使用的能耗大约为 5GW,是一个特大城市用电高峰的 1/4。

根据卓克在得到的一篇文章《科技参考3 - 148 | 追踪:往期内容的最新进展》所做出的预测,直到 2026 年,全人类的 10% - 15% 的能源将被 AI 使用。而只有绿色清洁能源的进步,才能应对这样的改变。

应用与影响

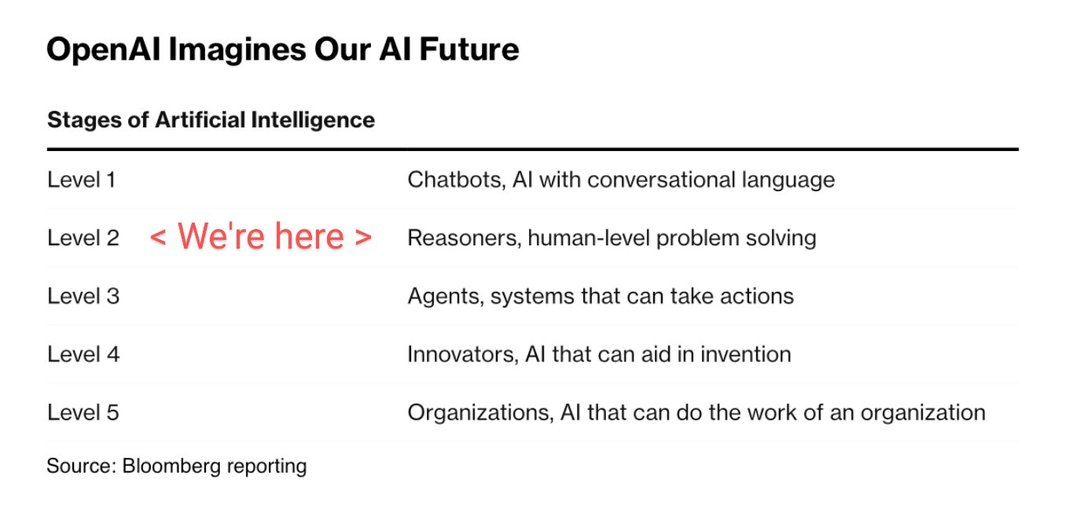

OpenAI 制定的 AI 路线进化图

2022 年的 ChatGPT 处于 Level 1 的水平,而我们当前(2024)正处在 Level 2 水平,这是一个 AI 可以协助推理,处理人类问题的水平。

根据以上进化图,可以了解到今后的 AI 将可能可以自主行为和协助创新。而就在 2022,我们还以为 AI 永远不可能帮助我们创新。

不过也应看出,这里面的路线图,AI 还是作为人的“助理”来提供帮助。这并代表 AI 在那时已经有了人的“意图”。据此我认为,AI 不太可能进化出人的意图,而只能按照人的指令行事。

应用领域

在 2017 年,迈克尔·乔丹(计算机教授)就预言,哪些事情是 AI 能做到的。他认为十年内以下几个领域 AI 是可以做到的:

- 无人驾驶

- 取代人的对话系统

- 跟踪人的健康

而在以下几个领域,AI 是做不到的(我认为其实是“做不好”的)

- 创造性的工作

- 总结概念并发明单词

- 变通的灵活性

- 学习完整的知识体系,并创造新的知识

从 2024 的视角看来,其实上述乔丹教授人为 AI 做不到领域,其实 AI 已经可以做了,就说“总结概念并发明单词”,GPT-4 就能做到,但只是也许没有“那么好”。关于创造新的知识而言,我相信在不久的将来,AI 通过统计方法,可以在不同领域找到大量目前人类仍然没有找到的知识,但这些知识有个上限,就是“数学可解的知识”。

一件事情做得好和做不好其实差别很大。目前 AI 给我的感觉就是他只是在有样学样的模仿,要创造真正的知识,例如爱因斯坦发现相对论,我觉得还是挺难的。

在这方面,我们还是应该参考机器学习系统的“数学上限”来判断一件事情 AI 是否可以完成。

审美和浪漫情怀

人有两个上帝赋予的特殊天赋是机器所无法取代的:一个是艺术的创造力和想象力,另一个是梦想和浪漫的情怀。如果你的生活和它们相关,你不用为自己担心,因为你总能想到机器想不到的事情。

—— 吴军 《见识》

有一点是 AI 永远无法得到的,那就是“美”。原因很简单,审美并不是一个数学问题,找不到唯一解。

我去过一些艺术展览,每个艺术家所想传达的内容,以及他的创作风格,都是无法“求解”的。正是因为艺术作品可以以各种各样的方式解读,所以才这么吸引人。

数学解决不了审美问题,那么 AI 也一定解决不了,这也就是为什么尽管 AIGC 可以很华丽,但是并没有内涵的原因。

社会对 AI 的焦虑

随着 GPT 在 2022 年的推出,基于 Transformer 算法的 AI 模型在和人交流中展示出的强大的智能,让人们既惊叹又焦虑。很多人担心自己的生活会被颠覆,工作会被取代。不仅人人自危,而且在社会大众媒体的不断渲染下,好像再过 10 年,生活中所有的东西都会被颠覆。

焦虑使人想要改变现状,于是很多人盲目跟风,在 AI 领域下注。各种 app 和应用层出不穷。然而直到 2024 年,在我自己对 AI 的实际应用中,我发现其使用局限性还是非常大,还远远不能替代人。

和所有工具的命运一样,人类在第一次见到自己不理解的技术的时候,总会产生各种恐惧,而现在人们对 AI 的恐惧也是一样。

《庄子》里有一个故事,讲的是一个老翁不用工具打水:

子贡在各国游历,偶遇一个种菜的老翁。只见他从井里打一罐水,用手抱着那个瓦罐走出好几步去给菜地浇水,十分费力。子贡就上前说,现在有一种设备叫桔槔,是个杠杆装置,一头吊一块大石头,另一头系着水桶,打水、移动都很轻便,你咋不用呢?

老翁说,我听说过那个技术,我是故意不用。那东西会让人有投机取巧之心,而这种思维会使心神不宁,破坏纯朴天性,人就不能承载大道了。子贡没想到老翁是个哲学隐者,感到很羞愧。

而现在的人们使用计算机的时间非常长,如果算上智能手机,几乎一天 24 小时都在和计算机打交道。如果有一个外星人在观察地球上的人类。他可能会认为人类已经是一个电子化的物种了,和浑身金属的人造人没什么两样。

人类社会的信任危机

造成这个问题的主要原因来自于深伪技术(deepfake)。

随着 AIGC 的发展,大量内容可被生成,而且生成速度非常快。这就造成了人与人之间的信任危机,因为人可能无法判断哪些内容是 AIGC 而哪些不是。

不过这并不是一个新的问题,随着互联网和自媒体技术的发展,信息的真实性判断已经变得越来越困难。大多数自媒体上的内容的第一目标是“获取流量”,进而获得收益,而真实性并不是这些自媒体机构的考虑目标。

获取关注和流量的本质是迎合人性,而人天生就喜欢“引起恐惧的”,“耸人听闻的”,“猎奇的”信息,这些信息往往是情绪化的,而不真实的。

而 AIGC 的发展使得虚假的信息显得更为真实,而近乎于无法辨认。

但是我认为这样的信息并不会成为社会的主流,人类社会总会找到办法去控制虚假信息的传播,利用技术手段也好,立法也好,我认为问题终将解决。

具身智能

尼克·查特拉思在《门槛》这本书中提到,AI 不具备人的体验能力。万维刚对此的总结是:

AI 在短期内无法做到比人更理解人

原因是人有身体,而 AI 没有。人有情绪,有呼吸,有同理心,这些是我们在万千年的演化中获得的,AI 没有进化的过程,也没有人的身体,所以它即使进化出了“意识”,也无法获得这种体验。

设想一下,AI 有了自主意识,那么他的意识一定是建立在“理性”的基础上的。没有情感,没有七情六欲,而只有计算。

就像星际迷航中的 Spock 先生,对他而言,逻辑优先于情感。我想 AI 一定会有过之而无不及。

正因如此,有人就想要弥补 AI 的这一个缺陷,让 AI 直接和环境互动。这就是“具身智能”这个概念的来源。就是让 AI 有自己的身体和感受,使其与环境真实互动,最终获得进化的机会。

尽管如此,机器人能解决的问题还是被局限在了“数学上限”的范围内。而不会像科幻电影里那样拥有真正的自主意识和智能。

AI 没有意识

AI 的极限究竟在哪里?而我认为有两件事 AI 一定做不到,第一件是“负责”,第二件是“主动”。

AI 不会感受到痛苦,所以它不会趋利避害。而人类社会中的惩罚对 AI 来说也毫无作用。另一方面,AI 没有自己的经历和文化传统,所以它一定没办法给自己安排一个什么事情,必须要去完成。

总的来说,就是 AI 没有意识。没有办法承担人类社会的责任,也没有能力去驱动一件事情的完成。