被广泛使用的机器学习算法,应用于语言理解和数据序列的操作。

Transformer 于 2017 年 Google Brain 团队提出。

注意力机制

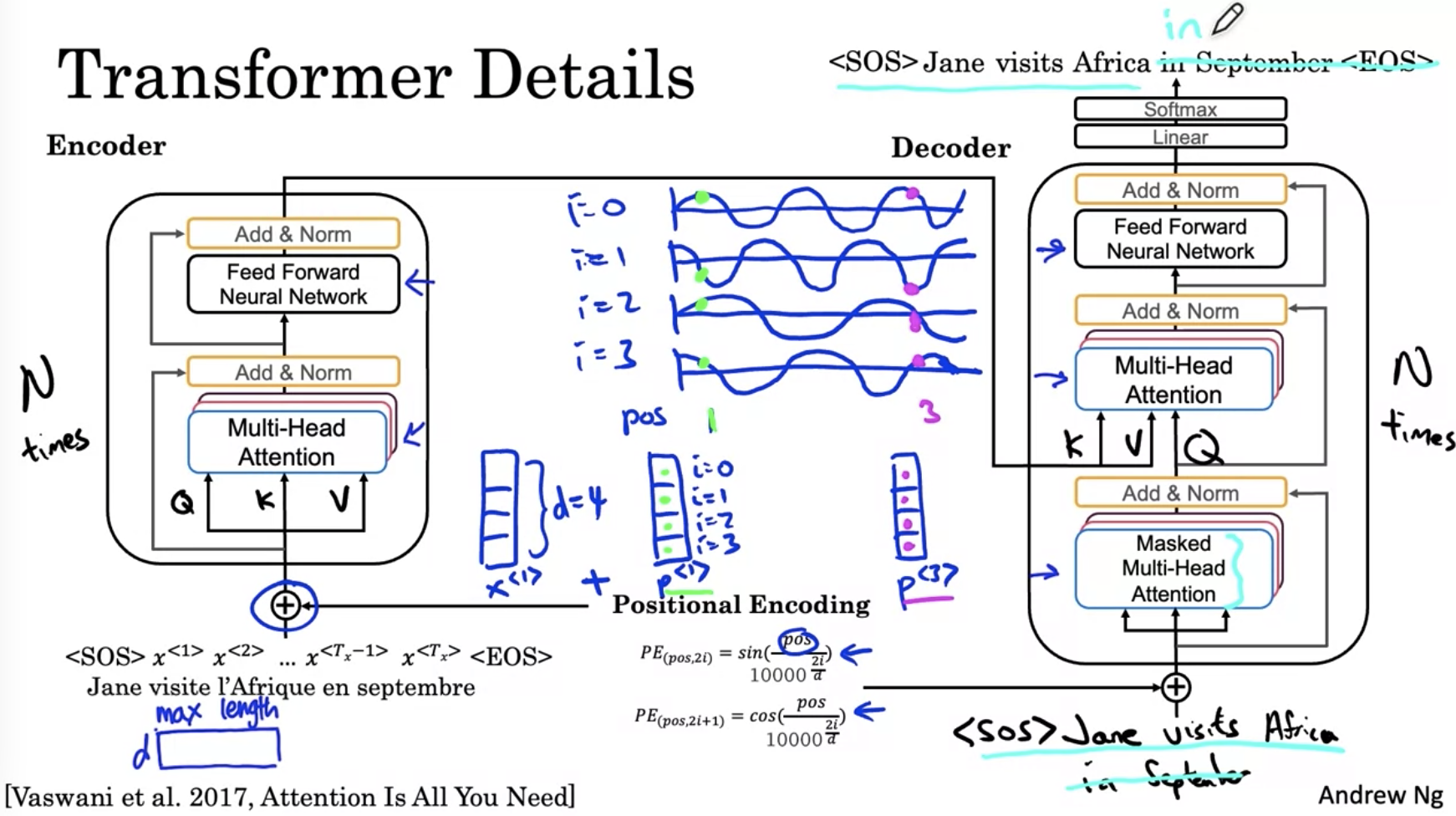

Transformer 中使用了注意力机制来计算词汇之间的关联程度。在模型中体现为 Q,K,V 三个不同的参数在模型不同模块之间的流动。

编码和解码机制

Transformer 使用了编码和解码两种不同机制,编码即为将输入内容编码为模型可以理解的数据。而解码即为将计算机理解的序列变成可供人类理解的语言。

在 Transformer 的编码解码过程中,即为将 Q K V 经过编码得到 K V。在另一个解码过程中,编码中获得的 K V 传入解码器。解码器中利用 Q 查询编码器中获得的 K V,得到一个关联的单词,作为模型的输出。